Christoph Straub, Javier Gonzalez, Rudolf Seitz, Bettina Felten, Ragasree Polepally, Peter Schauer und Nicole Schmeitzner

BeechSAT – Geschädigte Buchen mit Fernerkundungsdaten kartieren – LWF aktuell 128

LWF-Projekt sucht nach Möglichkeiten, absterbende Buchen mittels Luft- und Satellitenbildern automatisiert zu erfassen

Witterungsextreme wie Trockenperioden und das Auftreten von Extremtemperaturen in den letzten Jahren sind eine große Belastung für unsere Wälder. Im Jahr 2019 wurden insbesondere im Norden Bayerns zunehmende Schäden an Rotbuchen festgestellt. Die Fernerkundung kann dabei helfen, einen Überblick über das Ausmaß von Waldschäden zu bekommen.

Vor diesem Hintergrund wurden im Forschungsprojekt BeechSAT untersucht, ob und wie moderne Fernerkundungstechnologien und Auswerteverfahren aus dem Bereich des maschinellen Lernens automatisiert geschädigte und abgestorbene Buchen detektieren können.

Zoombild vorhanden

Zoombild vorhanden

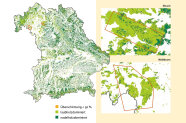

Abb. 1: Geografische Lage der Untersuchungsgebiete Waldbrunn und Ebrach. Im Hintergrund ist eine Laub-/Nadelholzkarte dargestellt. (Grafik: LWF)

Neben dem Einsatz von Luftbildaufnahmen sollte dabei insbesondere auch die Verwendbarkeit satellitengestützter Sensoren zur Schaddetektion getestet werden. Dabei lag der Schwerpunkt auf der Erfassung geschädigter hauptständiger Buchen. BeechSAT wurde als Kooperationsprojekt der LWF (Abteilungen: Informationstechnologie, Boden und Klima sowie Waldbau und Bergwald) mit der Firma IABG mbH durchgeführt und vom Bayerischen Staatsministerium für Ernährung, Landwirtschaft und Forsten finanziert.

Im Fokus der Untersuchungen lagen zwei Gebiete in Unter- und Oberfranken: Die Fläche mit der Bezeichnung Waldbrunn (Größe: 125 km²) liegt im Südwesten der Stadt Würzburg und beinhaltet den Irtenberger und den Guttenberger Wald. Die Fläche Ebrach (Größe: 50 km²) beinhaltet Ausschnitte vom Bürgerwald, Ebracher Forst und vom Koppenwinder Forst.

Abbildung 1 zeigt die Lage beider Untersuchungsgebiete mit der Laub-/Nadelholzkarte im Hintergrund. Ein wichtiges Kriterium für die Auswahl der Flächen war die unterschiedliche Dichte und Verteilung der geschädigten Buchen in den beiden Waldgebieten. So kommen in der Fläche Waldbrunn großflächigere Schäden vor, d.h. es sind neben einzelnen Bäumen auch größere zusammenhängende Baumgruppen betroffen, wohingegen die Schäden in Ebrach zum Aufnahmezeitpunkt eher kleinflächig bzw. einzelbaumweise auftreten.

Auswahl von Luft- und Satellitenbilddaten

Im Vergleich zu klassischen Orthophotos werden Baumpositionen in True-Orthophotos lagegenauer abgebildet (Straub & Seitz 2019). Parallel zur Luftbildbefliegung wurden Bilddaten unterschiedlicher Satellitensysteme beschafft. Schließlich standen für die Untersuchungen in BeechSAT folgende Datensätze zur Verfügung:

- Luftbilddaten (28.8.2019): 4 Spetralbänder mit 0,20 m Bodenauflösung

- WorldView-3 (30.8.2019: 8 Spektralbänder mit 1,20 m und ein panchromatisches Band mit 0,30 m Bodenauflösung

- SkySat (3.–4.9.2019): 4 Spektralbänder mit 1,10 m und ein panchromatisches Band mit 0,80 m Bodenauflösung

- PlanetScope Dove (3.9.2019): 4 Spektralbänder mit 3 m Bodenauflösung

- RapidEye (3.9.2019): 5 Spektralbänder mit 5 m Bodenauflösung

- Sentinel-2 (4.9.2019): 13 Spektralbänder mit 10 m, 20 m oder 60 m Bodenauflösung

Maschinelles Lernen zur Detektion geschädigter Bäume

Im Besonderen wurden Methoden des überwachten Lernens eingesetzt, d.h. im vorliegenden Fall wurde ein Verfahren zur semi-automatischen Klassifizierung geschädigter und vitaler Bäume in den Bilddaten vorab mit einem manuell erstellten Lerndatensatz »trainiert«. Deshalb wird der Lerndatensatz auch oft als Trainingsdatensatz bezeichnet. Bei der vorliegenden Fragestellung handelt es sich bei den Trainingsdaten um Bildbeispiele mit vitalen und geschädigten Baumkronen. Zum Einsatz kamen mehrere Methoden (s. Kasten).

Klassische Verfahren des maschinellen Lernens: Random Forest (Breiman 2001), Support Vector Machine (Cortes & Vapnik 1995) und künstliche neuronale Netze (Ripley 1996)

Deep Learning: Hierbei handelt es sich um einen Teilbereich des maschinellen Lernens, welcher derzeit als die fortgeschrittenste Anwendung von künstlichen neuronalen Netzen angesehen wird (Segl et al. 2018). Bei der Verarbeitung von Bilddaten kommen insbesondere Varianten des Convolutional Neural Network (LeCun et al. 2015) zum Einsatz.

Diese eignen sich in besonderem Maße, um Muster und Objekte in Bildern zu identifizieren. Im Unterschied zu den klassischen Verfahren des maschinellen Lernens werden beim Deep Learning in der Regel sehr viel größere Lerndatensätze eingesetzt. Aufgrund der rechenintensiven Trainingsphase wird entsprechend leistungsfähige Hardware benötigt.

Die räumliche Auflösung der Bilddaten ist besonders wichtig

Zoombild vorhanden

Zoombild vorhanden

Abb. 2: Ausschnitt der Untersuchungsfläche Waldbrunn: Luftbild-Satellitenbilddaten (oben) und das Ergebnis der semi-automatischen Klassifizierung (unten) (Grafik: LWF)

Die oberen Abbildungen zeigen jeweils Color-Infrarot (CIR)-Darstellungen der Fernerkundungsdatensätze. Abgestorbene Bäume können in den CIR-Bildern anhand von grün-bläulichen bis weißlich-grauen Farbtönen identifiziert werden, wohingegen vitale Baumkronen unterschiedliche Rottöne aufweisen (Ahrens et al. 2004). Die untere Abbildungsreihe zeigt das jeweils zugehörige Ergebnis einer semi-automatischen Bildklassifizierung. In roter Farbe sind die identifizierten abgestorbenen Baumkronen bzw. Baumgruppen dargestellt.

Die manuelle Erstellung der Trainingsdaten für die überwachte Bildklassifizierung ist der zeitaufwändigste Arbeitsschritt bei dieser Vorgehensweise. Die erzielbare Genauigkeit ist abhängig von der Qualität der Eingangsdaten, d.h. von der Repräsentativität der Trainingsdaten sowie vom Informationsgehalt der Fernerkundungsdaten. Der Informationsgehalt der Bilddaten muss vorab von einem erfahrenen Fernerkundungs-Interpreten begutachtet werden, um zu prüfen, welche Klassen in den vorliegenden Daten potenziell getrennt werden können.

Sofern durchführbar oder verfügbar, können Felddaten die Auswahl der Trainingsdaten erleichtern. Um Hinweise zur Baumart zu bekommen, können im Bayerischen Staatswald die Einzelbaummessungen an den Stichprobenkreisen einer Betriebsinventur unterstützend eingesetzt werden. Hierbei ist aber zu beachten, dass die manuelle Angleichung der Stammpositionen aus der Feldmessung an die räumliche Lage der Baumkronen in den Orthobilddaten einen beträchtlichen Arbeitsaufwand bedeuten kann.

Der Informationsgehalt der Fernerkundungsdaten ist besonders abhängig von der räumlichen Auflösung der Bilddaten. Dies soll Tabelle 1 verdeutlichen. Hier wurden Auswertungsmöglichkeiten für eine visuelle Bildinterpretation und für eine semi-automatische Bildklassifizierung getrennt für Einzelbäume und Baumgruppen für die im Projekt BeechSAT eingesetzten Fernerkundungsdaten beurteilt.

++ sehr gut / + gut / – bedingt möglich / -- nicht möglich / () Tendenz zur nächst schlechteren Kategorie

| Sensor (räumliche Auflösung) | Einzelbaum (visuelle Bildinterpretation/ semi-automatische Bildklassifizierung) | Baumgruppen (visuelle Bildinterpretation/ semi-automatische Bildklassifizierung) | Bemerkung |

|---|---|---|---|

| Luftbild (0,2 m) | ++/++ | ++/++ | Sehr gute Erkennbarkeit von Einzelbäumen, Baumkronenstrukturen sind erkennbar |

| WorldView-3 (0,3 m) | +/+ | ++/+ | Gute Erkennbarkeit von Baumgruppen, Erkennbarkeit von Einzelbäumen, Baumkronenstrukturen teilweise erkennbar |

| SkySat (0,8 m) | +/(+) | ++/+ | Gute Erkennbarkeit von Baumgruppen, teilweise Erkennbarkeit von Einzelbäumen, Keine Baumkronenstrukturen erkennbar |

| PlanetScope (3 m) | --/-- | +/(–) | Nur Baumgruppen erkennbar |

| RapidEye (5 m) | --/-- | +/(–) | Nur Baumgruppen erkennbar |

| Sentinel-2 (10 m) | --/-- | +/(–) | Nur große Baumgruppen erkennbar |

Bezogen auf die Satellitenbilddaten konnten mit den hochaufgelösten Sensoren WorldView-3 und SkySat die besten Ergebnisse erzielt werden. Die sehr hohe räumliche Auflösung des panchromatischen Kanals (0,3 m) von WorldView-3 kommt der Auflösung der Luftbilddaten (0,2 m) sehr nahe. Dadurch könnten in den WorldView-3 Bildern Trainingsdaten für hauptständige, abgestorbene Bäume erfasst werden, wenn man diese analog zu den Luftbilddaten mit dem DOM orthorektifiziert.

Bei allen anderen untersuchten Satellitenbilddaten (SkySat, PlanetScope, RapidEye und Sentinel-2) musste zur Erstellung der Trainingsdaten zusätzlich auf die Luftbilder zurückgegriffen werden. Lediglich in den SkySat-Daten sind einzelne Bäume noch teilweise erkennbar. Störend waren hierbei allerdings relativ starke Verkippungen der Baumkronen in den vorliegenden Bilddaten, die durch eine Schrägsicht des Sensors während der Aufname verursacht wurden. Bei PlanetScope, RapidEye und Sentinel-2 können einzelne Baumkronen nicht mehr identifiziert werden. Hier können geschädigte Bäume auch visuell nicht mehr zuverlässig von ähnlich gefärbten Bodenbereichen getrennt werden.

Demnach werden nach aktuellem Stand für die Sensoren SkySat, PlanetScope, RapidEye und Sentinel-2 zusätzlich Luftbildaufnahmen zur sicheren Trainingsdatengewinnung benötigt. In weiterführenden Projekten ist zu prüfen, ob es möglich ist, nur für Teilbereiche eines Untersuchungsgebiets Luftbildaufnahmen durchzuführen, mit dem Ziel unterschiedliche Topografien, Altersklassen und Schadmerkmale repräsentativ abzubilden, um dann die dort erstellten Trainingsdaten auf flächig vorliegende Satellitenbilddaten zu übertragen.

Bei der automatisierten Erfassung geschädigter und abgestorbener Bäume ist anzumerken, dass eine zuverlässige Unterscheidung von abgestorbenen Laubbaumkronen und abgestorbenen Nadelbaumkronen derzeit noch nicht gewährleistet werden kann. Eine Differenzierung der Schadbäume in Laub- und Nadelhölzer müsste derzeit nachträglich manuell anhand von Luftbildern erfolgen. Gegebenenfalls könnte die Nutzung von Texturmerkmalen aus Luftbildern zu einer automatisierten Trennung beitragen. Dieser Fragestellung werden wir in zukünftigen Studien wie zum Beispiel IpsSAT nachgehen .

Mit Deep Learning bessere Genauigkeiten

Zoombild vorhanden

Zoombild vorhanden

Abb. 3: Bereits im Oktober hat die durch Trockenheit stark gestresste Buche ihr Laub vorzeitig abgeworfen, während die Eiche (rechts) noch voll belaubt war. (Foto: S. Thierfelder)

Dennoch ist der Einsatz von Deep Learning von Fall zu Fall abzuwägen, insbesondere aufgrund der Notwendigkeit, dass – im Vergleich zu herkömmlichen Methoden – ein größerer Trainingsdatensatz benötigt wird. Wenn dieser allerdings ausreichend groß und divers genug ist, wäre der Einsatz von Deep Learning zu empfehlen.

Ferner kann derzeit noch nicht davon ausgegangen werden, dass der in BeechSAT verwendete Trainingsdatensatz ausreicht, um die aktuell erstellten Klassifikationsmodelle ohne erneutes Training auf andere Untersuchungsgebiete übertragen zu können. Um dies zu ermöglichen, müssten weitere Projektfflächen mit zusätzlichen Fernerkundungsdaten einbezogen werden. Sofern es zukünftig gelingt, ein übertragbares Deep Learning-Modell auf der Grundlage eines erweiterten Trainingsdatensatzes zu erstellen, wäre bei der Anwendung in neuen Gebieten theoretisch kein erneutes Training mehr nötig.

Ausblick: Erfassung von Borkenkäferschäden an Fichte

Zusammenfassung

Zum Einsatz kamen hierfür sowohl klassische Verfahren des maschinellen Lernens als auch fortgeschrittenere Methoden wie Deep Learning. Zum Training der Algorithmen wurde manuell ein umfangreicher Trainingsdatensatz erstellt. BeechSAT konnte zeigen, dass eine automatisierte Erfassung abgestorbener Bäume mit Fernerkundungsdaten grundsätzlich möglich ist. Dabei zeigte sich, dass die räumliche Auflösung der Bilddaten sowohl für eine visuelle Bildinterpretation als auch für eine semi-automatische Auswertung besonders wichtig ist.

Luftbilddaten mit der höchsten räumlichen Auflösung bieten die besten Möglichkeiten zur Erkennung von geschädigten Bäumen. Der Vergleich der getesteten maschinellen Lernverfahren zeigte, dass mit Deep Learning etwas bessere Genauigkeiten erzielt werden konnten. Bei einer automatisierten Auswertung ist derzeit noch keine zuverlässige Unterscheidung von abgestorbenen Laubbäumen und abgestorbenen Nadelbäumen möglich.

Literatur

- Ahrens, W.; Brockamp, U.; Pisoke, T. (2004): Zur Erfassung von Waldstrukturen im Luftbild. Waldschutzgebiete Baden-Württemberg, Band 5, Forstliche Versuchs- und Forschungsanstalt Baden-Württemberg, 56 S.

- Breiman, L. (2001): Random Forests. Machine Learning, 45, S. 5–32

- Cortes, C.; Vapnik, V. (1995): Support Vector Networks. Machine Learning, 20, S. 273–297

- LeCun, Y.; Bengio, Y.; Hinton, G. (2015): Deep learning. Nature, 521, S. 436–444

- Ripley, B.D. (1996): Pattern Recognition and Neural Networks. Cambridge University Press

- Segl, K.; Bohn, N.; Chabrillat, S.; Neumann, C.; Roessner, S.; Ward, K.; Wolanin, D. (2018): Maschinelles Lernen bei der Auswertung von Fernerkundungsdaten. System Erde, GFZ-Journal, 8(1), S. 18–25

- Straub, C.; Seitz, R. (2019): Lagegenaue Erfassung von Bäumen aus dem Flugzeug. LWF aktuell 122, S. 47–49

Beitrag zum Ausdrucken

Weiterführende Informationen

Autoren

- Christoph Straub

- Javier Gonzalez

- Rudolf Seitz

- Bettina Felten

- Ragasree Polepally

- Peter Schauer

- Nicole Schmeitzner